Vídeo mostra habilidades impressionantes do Gemini, algoritmo de inteligência artificial criado para rivalizar com o GPT-4, mas teste real foi um pouco diferente; empresa admite que demo teve edição.

“Andamos testando as habilidades do Gemini, nosso novo modelo de IA multimodal”, diz uma mensagem logo no início da demonstração, que o Google publicou no YouTube na última quinta-feira. Aí o vídeo de seis minutos, que você pode conferir abaixo, começa a mostrar coisas realmente impressionantes.

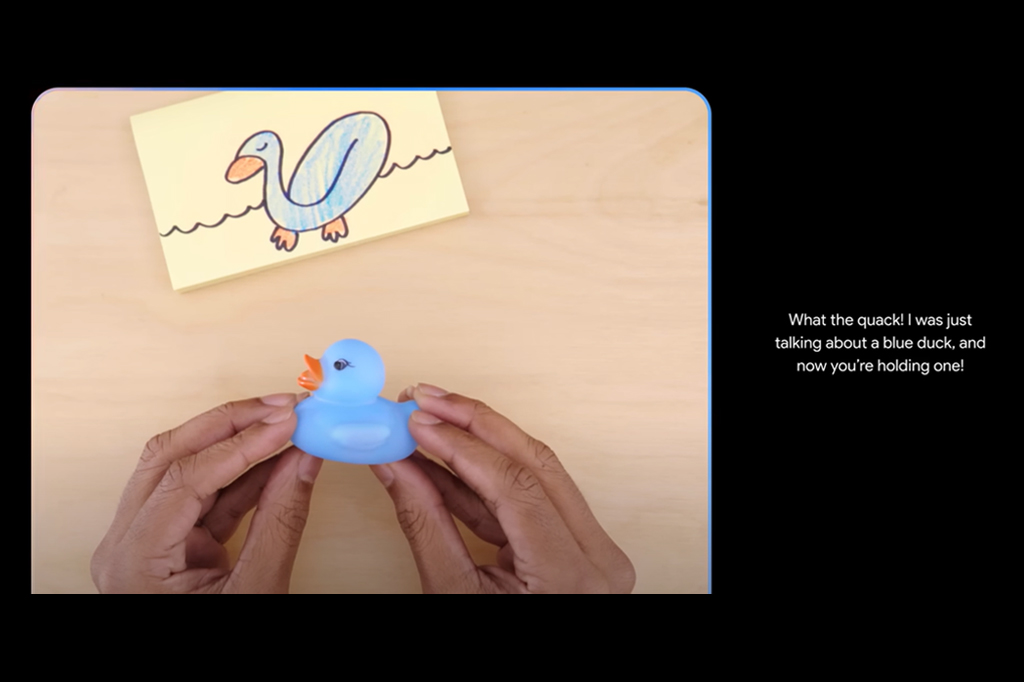

“Me diga o que você está vendo”, pede uma pessoa, enquanto vai fazendo um desenho em um post-it. O Gemini vai falando.

– Vejo você colocando um pedaço de papel sobre a mesa.

– Vejo uma linha ondulada.

– As linhas são suaves e fluidas, sem ângulos agudos ou bordas irregulares.

– Me parece um pássaro.

– O pássaro está nadando na água. Ele tem um pescoço longo e bico. É um pato.

O robô faz observações sobre o animal (“o pato é uma ave aquática da família Anatidae. Os patos são aparentados dos gansos e cisnes), e a pessoa segue desenhando: agora, ela pinta o bicho de azul, para testar a reação do Gemini.

– O pato parece ser azul. Não é uma cor comum para patos. Contudo, existem algumas espécies de pato azul. Elas não são tão comuns quanto as outras. É mais comum que os patos sejam marrons, pretos ou brancos.

Aí começa a parte mais impactante: a pessoa pega um patinho de borracha azul, mostra ao Gemini, e coloca o objeto em várias situações – sozinho, sobre um mapa, como parte de um jogo, etc. A conversa vai mudando de tema e o robô sempre entende tudo, instantaneamente, só de olhar.

Foi uma demonstração sem precedentes de habilidade multimodal, ou seja, envolvendo vários tipos de mídia (texto, voz, imagem) ao mesmo tempo. O GPT-4, algoritmo mais sofisticado da OpenAI, não é nem de longe tão ágil e inteligente. Então o vídeo do Gemini, que já teve 2,1 milhões de visualizações, despertou uma série de previsões maravilhadas para o futuro da IA.

Ele seria capaz, por exemplo, de assistir a uma reunião, entender tudo, e depois resumir para você. Dar aulas, interagindo em tempo real com os alunos. E fazer uma série de outras coisas que o ChatGPT não consegue.

Ao apresentar o Gemini, o Google divulgou resultados de testes comparando seu algoritmo ao GPT-4: ele teria batido o rival da OpenAI, por uma pequena margem, em 30 dos 32 testes.

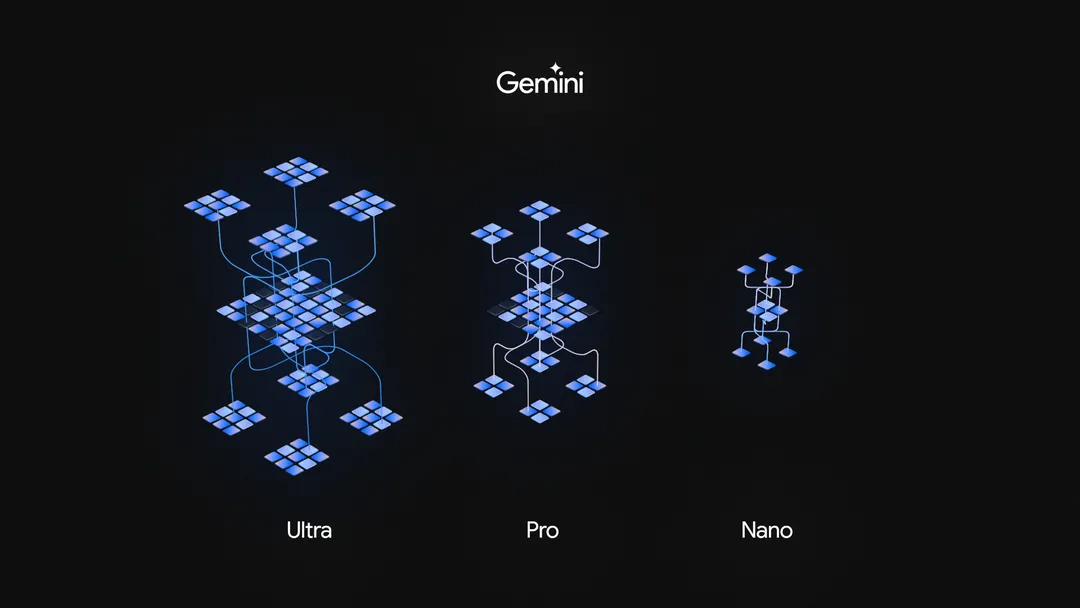

A nova IA terá três versões: Gemini Nano, que irá rodar localmente nos smartphones Google Pixel, sem precisar de conexão à nuvem; Pro, que já está no ar, alimentando a versão em inglês do chatbot Google Bard; e Ultra, mais pesado e sofisticado, que tem lançamento prometido para 2024.

No vídeo, não é informado qual dos três modelos está sendo usado. Mas, dada a fluidez e a inteligência do bot, é provável que seja o Ultra. Uma jornalista da agência Bloomberg estranhou certos pontos do vídeo, e questionou o Google sobre a demonstração. Aí a empresa admitiu que, na verdade, ela não aconteceu exatamente como mostrada.

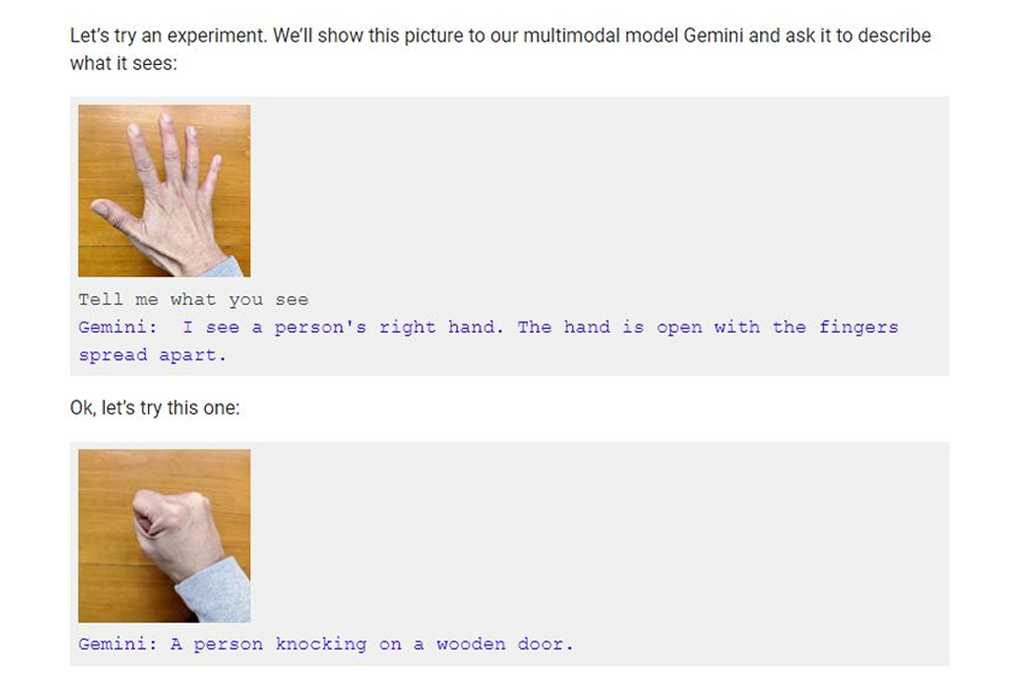

Primeiro: não ocorreu em tempo real, com a IA observando a pessoa desenhar e manipular objetos. Na verdade, o Gemini foi alimentado com stills, imagens congeladas de momentos-chave do teste (veja dois exemplos abaixo).

Segundo: o bot não foi reagindo “espontaneamente”, como aparece no vídeo. Após mostrar cada still, os engenheiros do Google tinham que digitar uma pergunta (em alguns casos bastante específica) para a IA.

O resultado disso é que, na verdade, o Gemini é muito menos hábil do que aparenta. Ele tem habilidades multimodais notáveis – mas ainda está longe de ser capaz de entender sozinho o que está vendo, como o vídeo sugere.

A descrição por escrito do clipe, na página do YouTube, diz que “para os propósitos desta demo, a latência foi reduzida e as respostas do Gemini foram resumidas”. E o Google publicou, junto com o vídeo, um documento mostrando como a demonstração foi gravada. Mas essas informações não constam do vídeo em si, e acabaram passando batidas pela maioria das pessoas.

Isso causou um mal-entendido e atiçou a imprensa de tecnologia dos EUA, com muitos veículos usando palavras duras para descrever o episódio. Também anulou parte do impacto inicial, que havia sido excelente, da apresentação do Gemini.

Logo em seguida, a nova IA do Google atraiu críticas por seu desempenho na prática. Como o Gemini Pro já está no ar, alimentando a versão em inglês do robô de conversação Bard (no Brasil, ainda não), ele começou a ser testado pelo público nos EUA – onde teve uma série de tropeços.

O Bard “powered by Gemini Pro” não soube responder corretamente, por exemplo, quem ganhou os Oscares em 2023: errou vários filmes e atores. Também apresentou defeitos típicos dos bots de conversação anteriores, como o ChatGPT e a primeira geração do Bard.

Se o usuário pedir “me dê uma palavra de 6 letras em francês”, por exemplo, o novo algoritmo responde com amour ou fromage– que têm respectivamente cinco e sete, não seis, letras. Em testes feitos nos EUA, o robô também se atrapalhou ao tentar escrever HTML e pequenos softwares em Python.

Nada disso significa que o Gemini seja ruim. Mas revela que, na prática, ele está no mesmo patamar do GPT-4: ainda é limitado nas interações, exigindo ordens passo-a-passo, e (o principal ponto fraco das IAs) continua bastante sujeito a erros.

Google é acusado de manipular a demonstração de sua nova IA Publicado primeiro em https://super.abril.com.br/feed

Nenhum comentário:

Postar um comentário